什么是 LM Studio?

LM Studio是一款面向普通用户的桌面应用程序,它的核心作用是让你能在自己的电脑(Windows、mac或Linux)上,无需联网、直观地下载和运行各种开源的大型语言模型(LLM),就像在本地运行一个属于你自己的AI助手。

核心特点

- 图形界面:提供直观的窗口操作,无需编写代码,适合非技术用户。

- 完全离线:所有模型和数据都在本地处理,能确保隐私安全,无网络也能使用。

- 易于上手:内置模型市场,可一键搜索、下载和加载模型,开箱即用。

- 硬件加速:能自动利用你的电脑GPU(如NVIDIA CUDA或Apple Metal)来提升运行速度。

- 兼容性强:支持众多热门的开源模型(如Llama、DeepSeek、Mistral等),尤其是 GGUF格式的模型。

配置要求

- 操作系统:Windows、macOS (包括Apple Silicon芯片) 或 Linux。

- 内存 (RAM):建议至少16GB。运行7B参数的小模型勉强够用,更大模型需要更多内存。

- 硬盘空间:至少预留10-50GB,因为模型文件通常很大。

- 显卡 (GPU):非必须,但有独立显卡(如NVIDIA GTX 1060 6GB或更高)能显著提升速度。

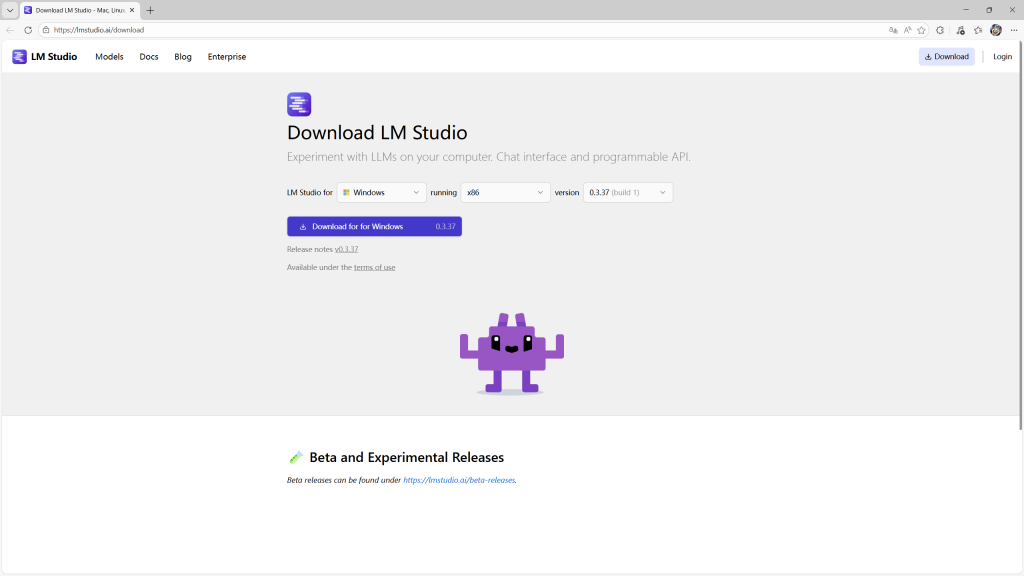

安装教程

前往LM Studio官网下载适用于您的操作系统的安装程序。

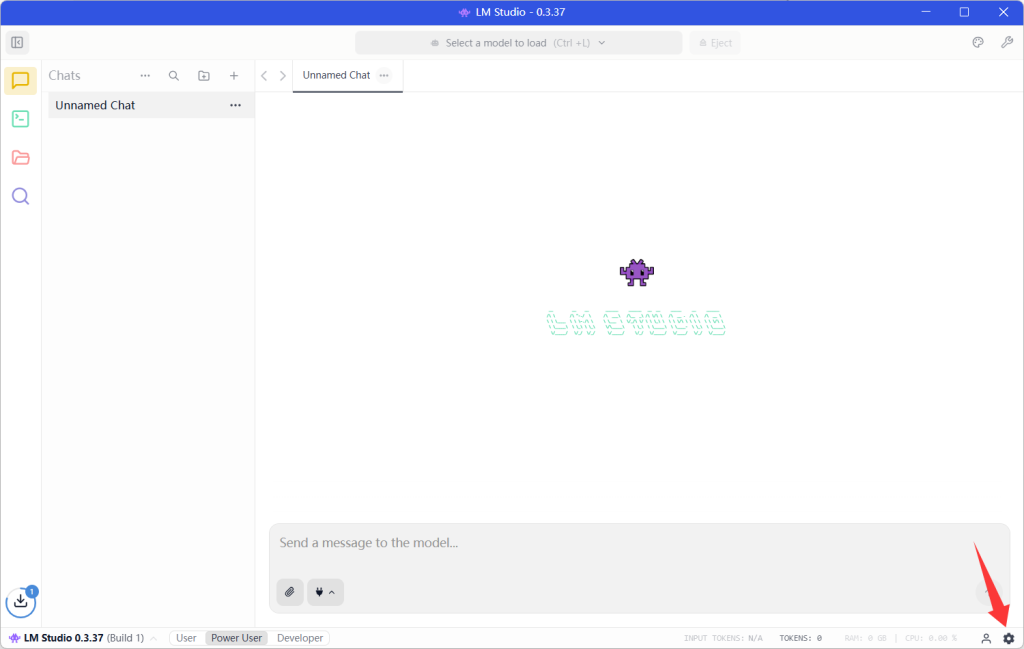

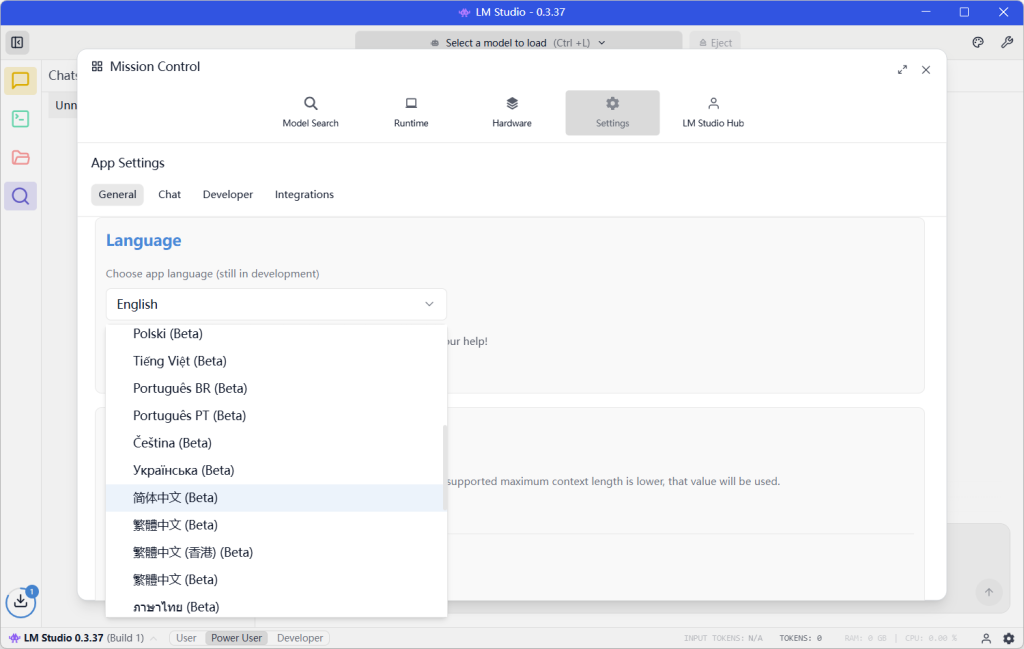

设置中文

- 先点击右下角设置按钮。

- 在打开的界面往下翻找到Language设置简体中文。

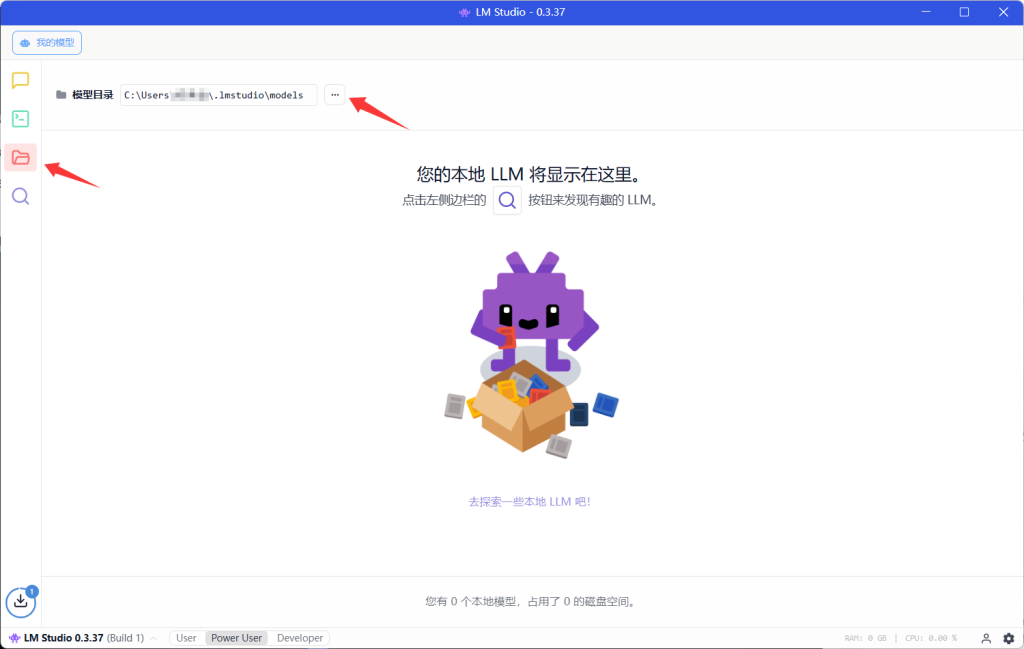

更改模型目录

- 点击左侧第三个图标打开我的模型。

- 在模型目录右边点击模型目录选项更改模型目录。

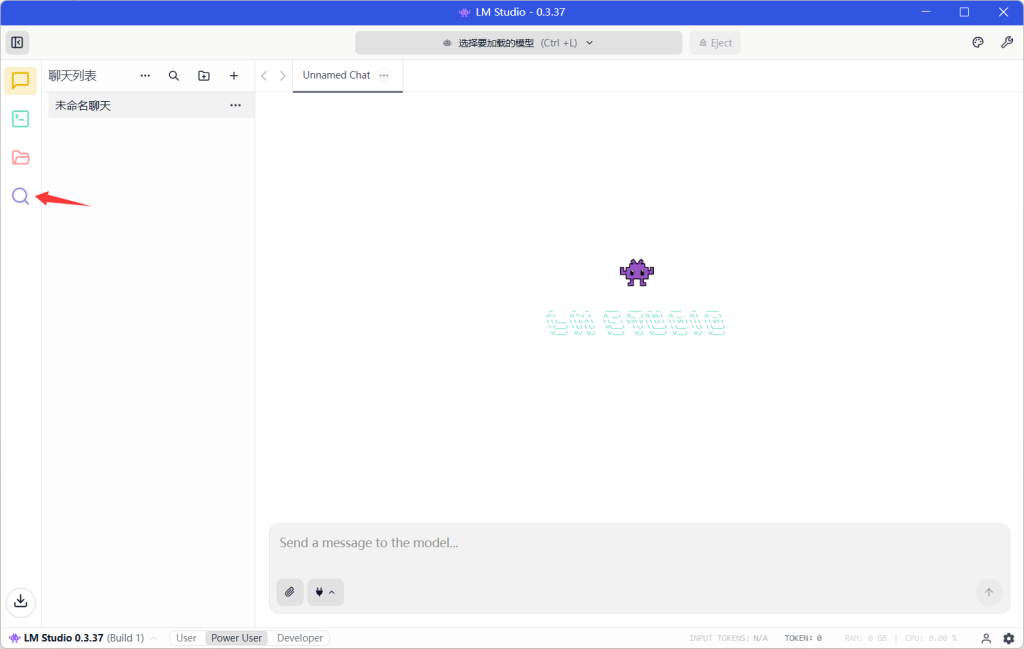

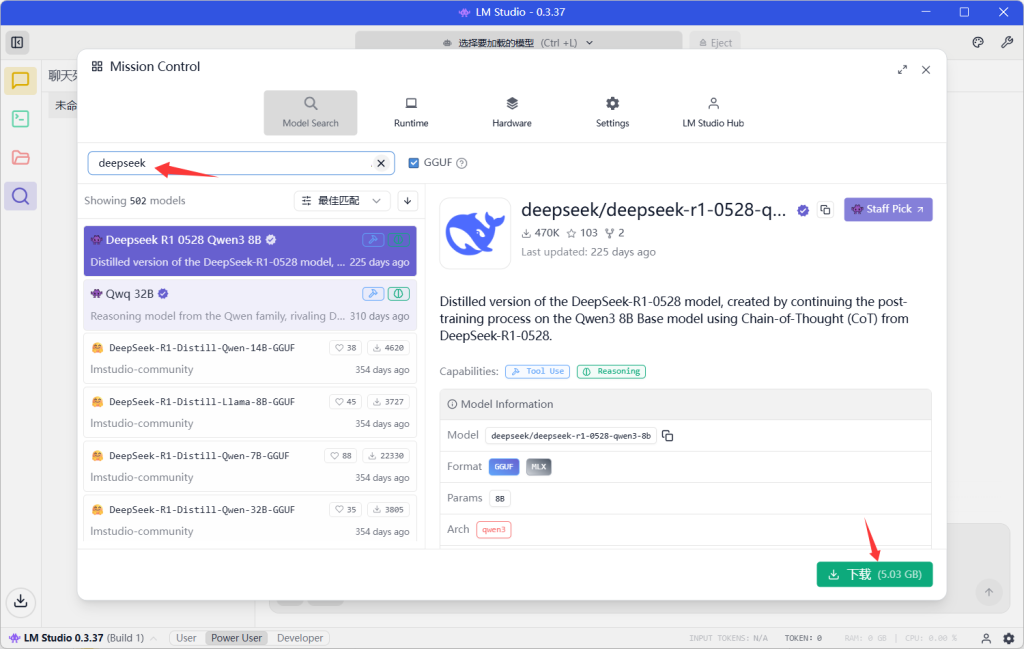

通过LM Studio内置模型库下载

- 点击左侧第四个图标打开。

- 搜索栏输入模型名称。

- 找到适合电脑配置的模型在右下角点击下载。

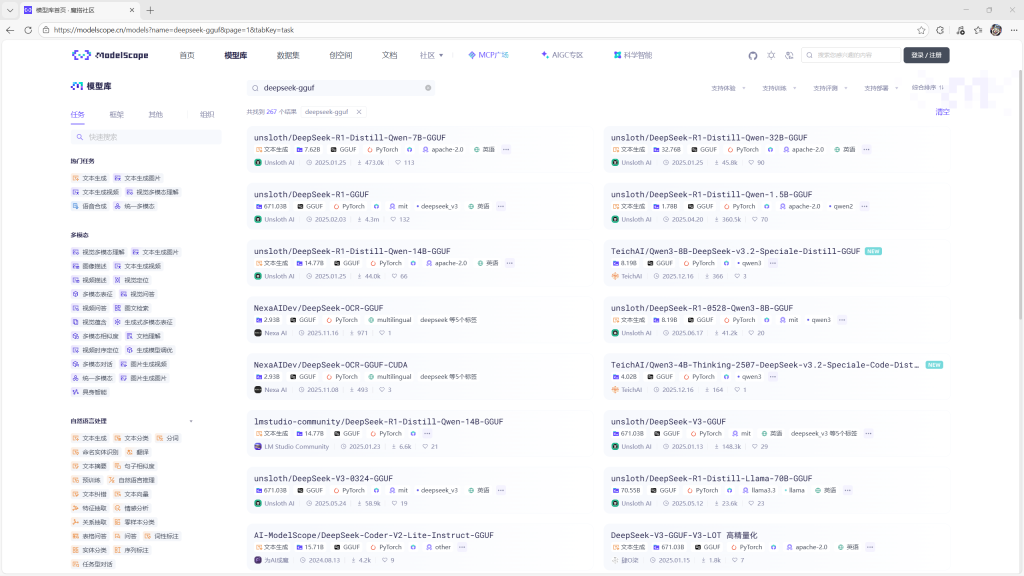

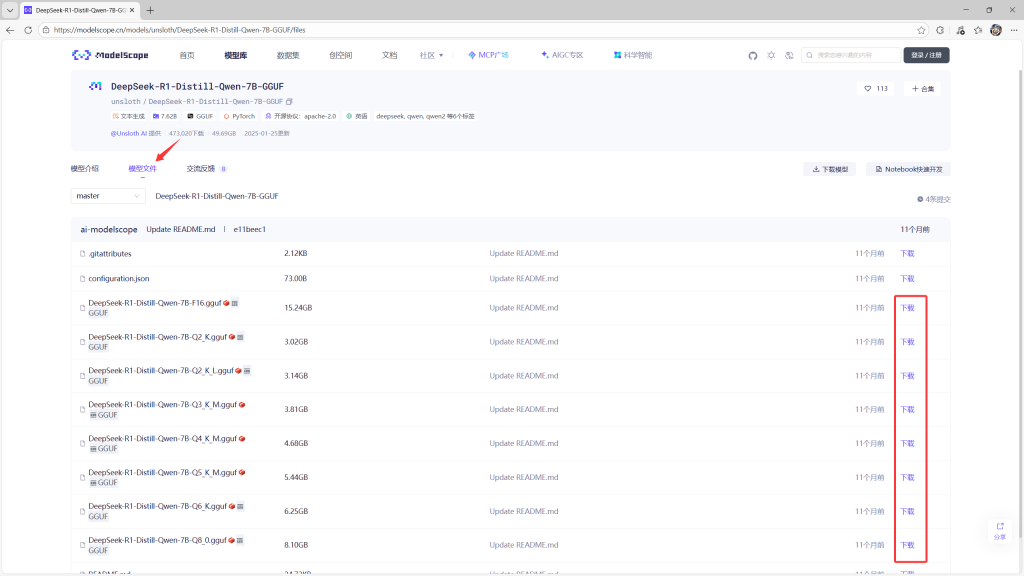

通过镜像网站下载模型

阿里魔搭社区 (ModelScope):这是Hugging Face官方仓库的国内高速镜像,可以直接下载几乎全部开源的GGUF模型文件。

- 在搜索框输入模型名称-gguf。

- 选择一个模型点开,点击模型文件,找到一个接近显存(比显存小)的模型下载。

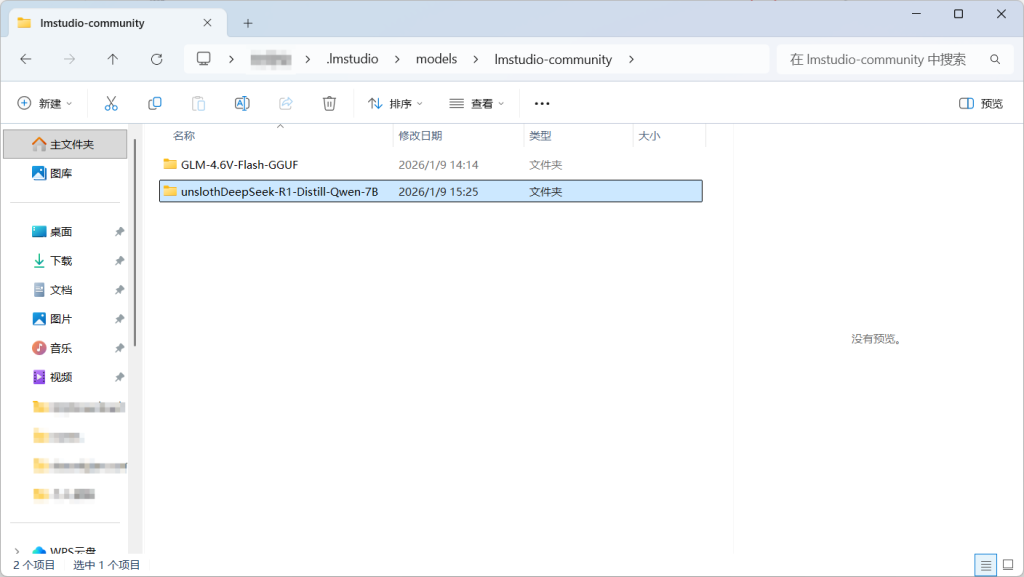

- 下载完成后再模型目录新建一个文件夹,文件夹名称建议改成模型名称,将下载好的模型文件复制到文件夹内。

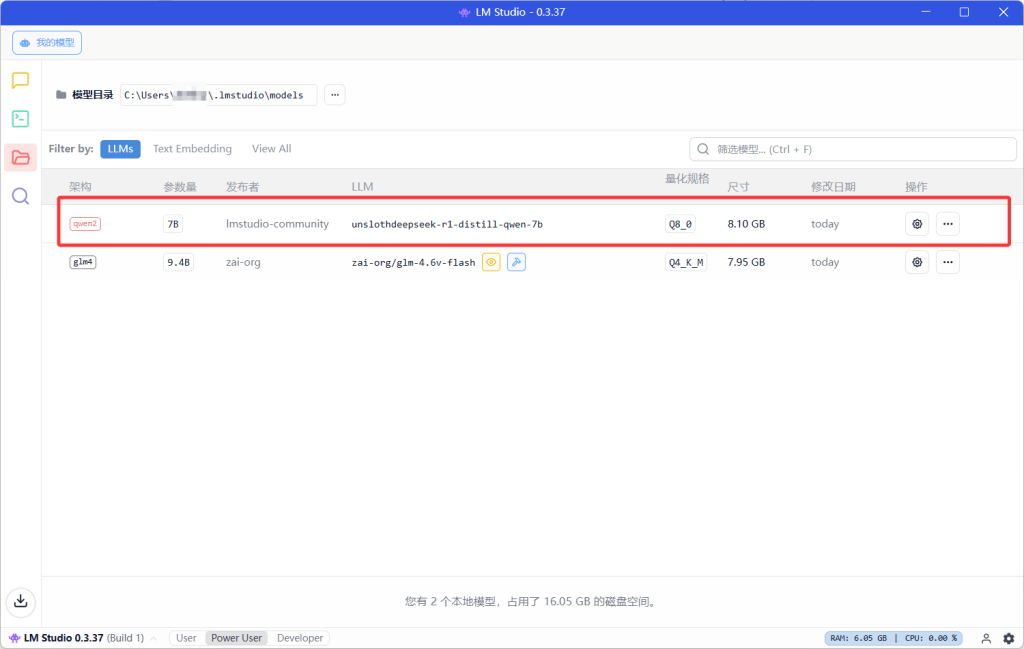

- 打开我的模型就能看到下载好的模型。

启动模型

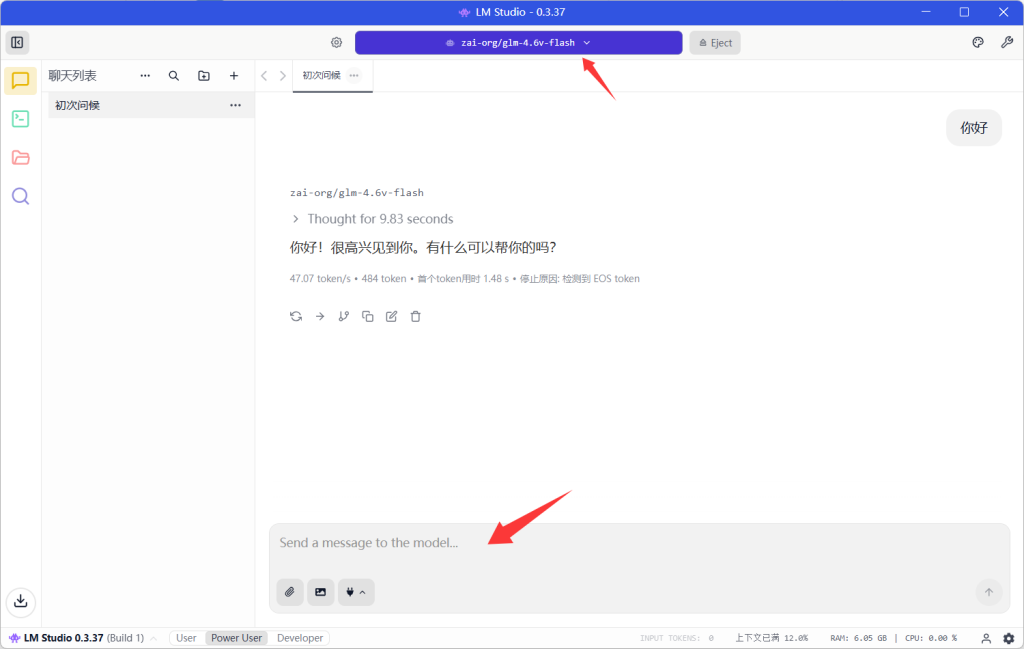

在聊天页面上方选择模型,等待模型启动完成后就可以使用了。

API调用方式

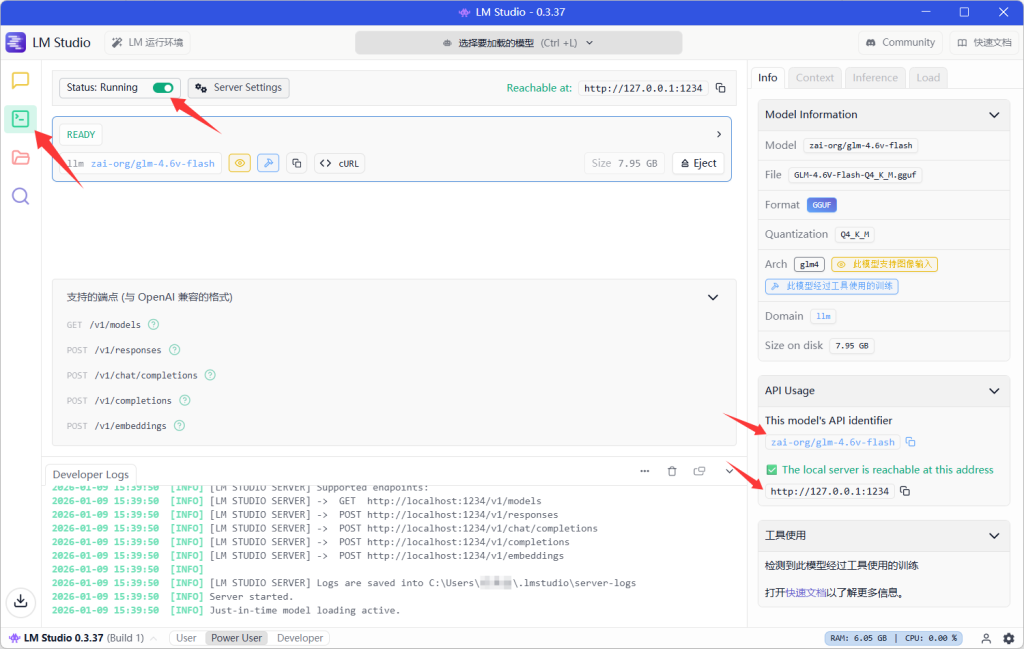

- 启动模型,打开开发者页面。

- 开启页面上方的Status:Running(绿色)。

- 右边有模型名称和本地调用模型的地址。

Python API调用

安装openai

pip install openai修改模型名称和地址,运行Python程序

from openai import OpenAI

client =OpenAI(

base_url="http://127.0.0.1:1234/v1",

api_key="not-needed",

)

response=client.responses.create(

model="zai-org/glm-4.6v-flash",

input=[

{

"role":"user",

"content":"你好,你是谁?"

}

]

)

print(response.output_text)